近日,第 32 届知识发现与数据挖掘国际会议(The 32nd ACM SIGKDD Conference on Knowledge Discovery and Data Mining, KDD 2026)公布录用论文名单,组内博三学生吴斌权的研究论文《Interest Entropy: Rethinking Contrastive Learning for Sequential Recommendation with Interest Uncertainty》成功入选,为团队在推荐系统领域的学术研究再添重要成果。

KDD 是数据挖掘领域最具影响力的顶级学术会议之一,由 ACM SIGKDD 主办。自1989年创办以来,KDD已成为数据科学、机器学习和人工智能领域的重要交流平台。据 KDD 官方统计,近年来会议投稿量持续增长,竞争愈发激烈,今年整体接收率保持在严格的学术筛选标准之下,凸显了本次入选成果的含金量。

论文题目:Interest Entropy: Rethinking Contrastive Learning for Sequential Recommendation with Interest Uncertainty

作者:Binquan Wu, KunZeng, Yicheng Luo, Junhao Zheng, Qianli Ma*

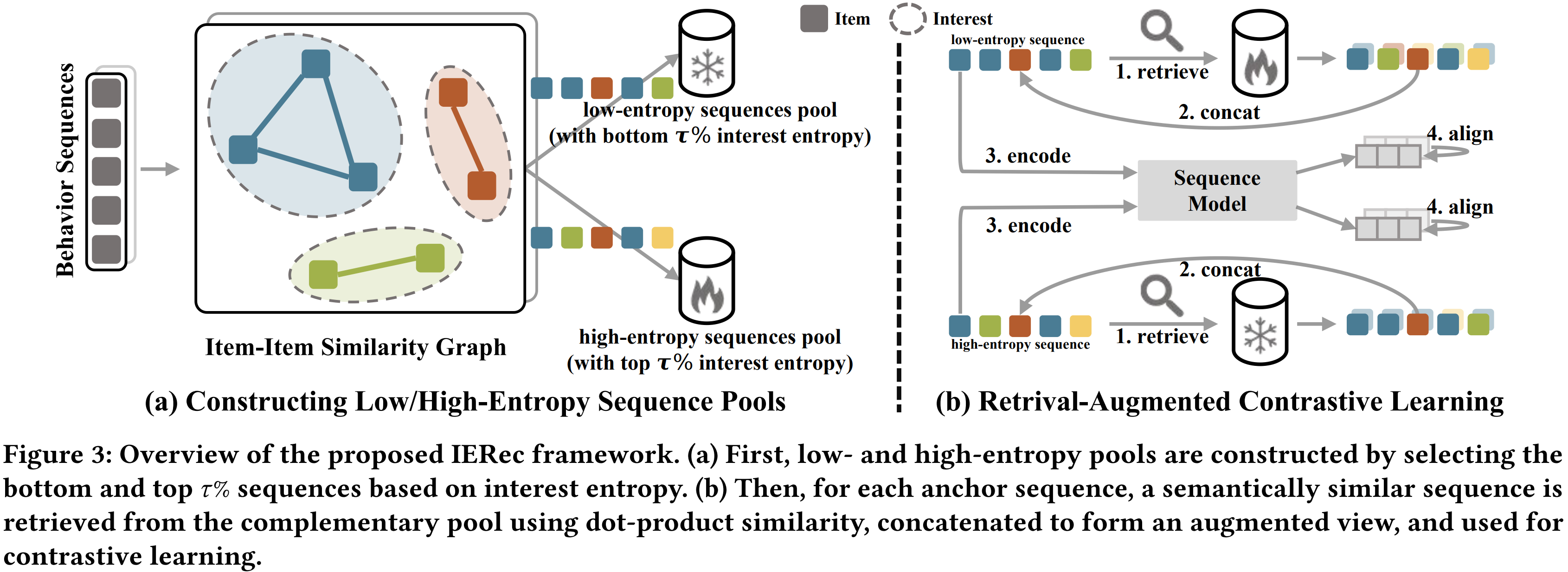

论文简介:本文首先通过兴趣熵(衡量兴趣分布的多样性和密度)来探讨扩增对序列语义的影响。我们的发现表明,只有极少数序列在微扰下是稳定的。这些序列主要表现出低或高熵,反映出专注或随意的兴趣。这限制了对比学习的有效性,而对比学习依赖于语义一致的正对。此外,通过谱分析,我们表明正比对可能导致低熵序列忽略生态位兴趣,而高熵序列可能放大无关兴趣信号,我们称之为语义偏见。最后,基于兴趣熵,我们提出了IERec,一种简单但有效的互检索增强对比学习框架,能够统一缓解上述问题。对于每个锚点序列(熵低或高熵),我们检索一个语义相似且兴趣熵互补的序列,并将其串接形成正向视图。容易受影响的序列,主要是中等熵的序列,被排除在扩增之外。这种方法可以避免正对的有害语义差异,减少语义偏倚的影响,从而提升性能。此外,利用兴趣熵指导对比学习,可以提升现有基于兴趣熵的对比学习方法的性能。

GitHub链接:https://github.com/qianlima-lab/IERec