近日,国际学习表征会议(International Conference on Learning Representations, ICLR 2025)论文接收结果公布,组里有2篇论文被录用,第一作者分别是博士生冯华文、郑俊豪同学。ICLR被认为是深度学习领域的顶级国际会议之一,将于2025年4月24日至28日在新加坡举行,展示人工智能与深度学习领域的最新进展和突破性研究。

论文题目:Training Large Language Models for Retrieval-Augmented Question Answering through Backtracking Correction

作者:Huawen Feng, ZekunYao, Junhao Zheng, Qianli Ma*

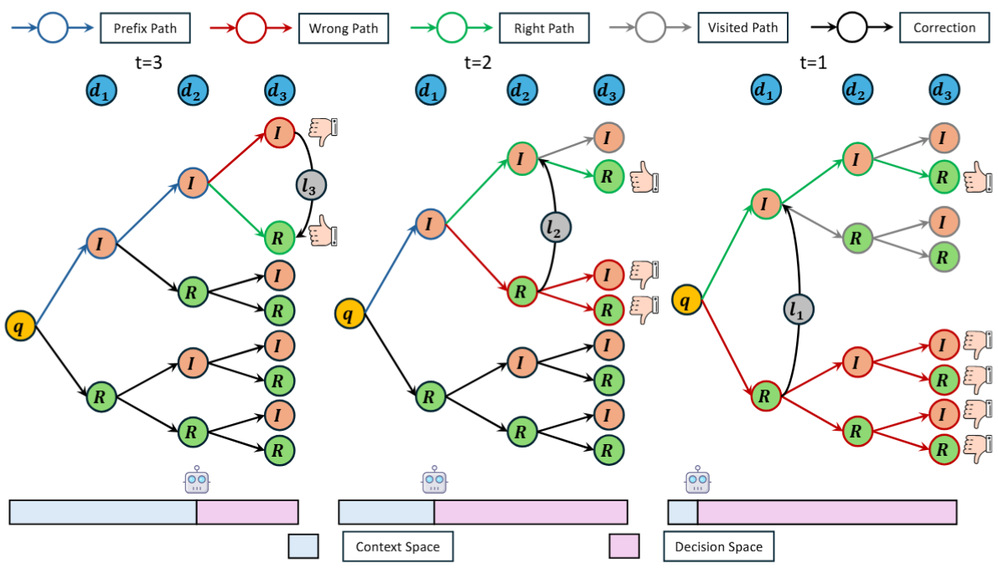

论文简介:近年来,基于大规模语言模型(LLMs)的检索增强生成(RAG)取得了一定进展,但检索器经常召回与任务无关的文档,影响模型输出。为了解决这个问题,一些方法通过训练LLMs区分相关与不相关文档,训练LLMs在多个文档间进行逐步推理(多步RAG)。不过,这些方法需要大量高质量标注数据,训练成本很高。本文提出了一种名为“回溯修正”(Backtracking Correction)的方法,解决了这一挑战。我们将多步RAG看作一个多步骤决策过程,从最终步骤开始,通过错误采样和自我修正逐步优化模型,再回溯到前一个状态。实验表明,这种方法能提高LLMs在处理复杂任务时的表现,并增强RAG对噪声文档的鲁棒性。

模型代码:稍后更新。

论文题目:Spurious Forgetting in Continual Learning of Language Models

作者:Junhao Zheng, Xidi Cai, Shengjie Qiu, Qianli Ma*

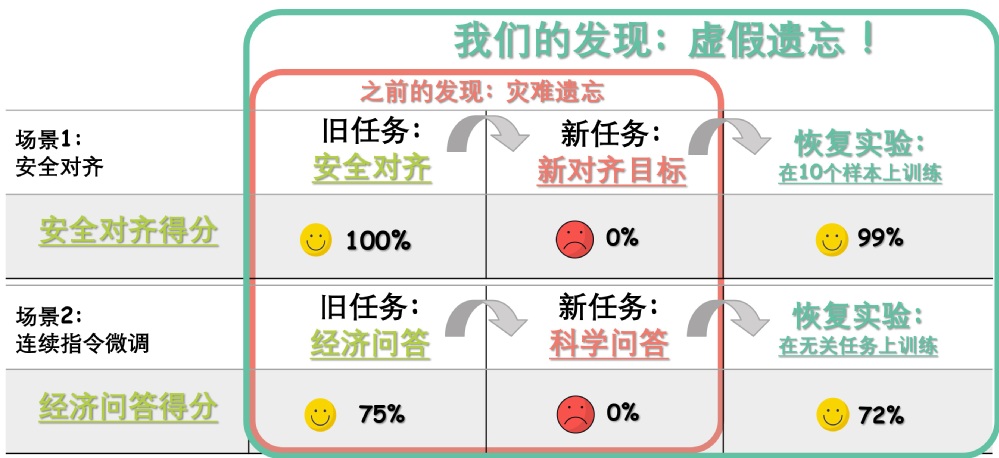

论文简介:该论文研究了语言模型在持续学习中的虚假遗忘(Spurious Forgetting)现象,并发现性能下降的主要原因并非真正的知识遗忘,而是任务对齐(Task Alignment)的丧失。研究通过合成数据集和理论分析揭示了模型底层网络层在任务对齐中的关键作用,并通过权重更新的正交性分析解释了该现象。基于此,论文提出了一种冻结底层参数(Freeze Strategy)的策略,以减少任务对齐的丧失,从而缓解虚假遗忘问题。实验表明,该方法在安全对齐、指令微调、知识编辑等多种持续学习场景中均能显著提升模型性能。该研究不仅为持续学习提供了新的理解视角,也提出了一种简单高效的改进方案,为未来改进大语言模型的持续学习能力提供了重要借鉴。

模型代码:https://github.com/qianlima-lab/spurious-forgetting

相关媒体报道:ICLR 2025 | 大模型“遗忘”竟是错觉?华南理工团队首次揭示LLM训练中的“虚假遗忘”