| 突破高清抠图瓶颈:通过精炼低分辨率前景遮罩实现高分辨率自然图像抠图 |

| 发布时间: 2025-10-11 浏览次数: 12 |

|

作为计算机视觉领域的“数字手术刀”,图像抠图(Image Matting)通过精准估计前景不透明度(Alpha Matte)实现主体与背景的像素级分离,早已渗透到视觉创作的每一个角落。在电商场景中,它能为珠宝、服饰等商品剥离杂乱背景,让产品细节清晰呈现,直接提升用户购买欲;影视后期里,它是绿幕特效的核心支撑,让演员“穿越”到任何虚拟场景,同时保留发丝、衣角的自然质感;即便是日常视频会议,抠图技术也能通过背景替换保护隐私,让杂乱房间秒变专业演播室;遥感成像中,图像抠图可精准分离地表覆盖物与干扰要素,助力土地利用分析、植被监测与城市规划,显著提升遥感数据解译精度与自动化处理能力。可以说,抠图精度直接决定了视觉内容的创作自由度与呈现品质。 而随着5K相机、8K显示器等硬件设备的普及,高分辨率(High-resolution)图像抠图正成为新的技术核心——用户不再满足于“看清主体”,更追求“看清细节”:珠宝的金属纹理、织物的纱线结构、透明玻璃的光影折射,这些亚像素级细节的呈现,往往是专业创作与普通处理的分水岭。然而,高分辨率带来的海量像素数据,却让传统抠图方法陷入了“精度与效率”的两难困境。

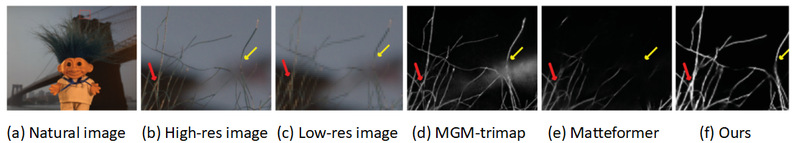

一、直击痛点:高清抠图的无解悖论 现有技术处理高分辨率图像时,始终存在无法调和的矛盾: (一)直接硬算的“算力陷阱”:若直接对4K、8K 图像建模,模型的计算量会呈指数级增长[1, 2, 3],即便是高端GPU也难以承受,推理速度常跌破每秒1帧,完全无法满足影视后期、实时直播等实际需求; (二)降采样处理的“细节牺牲”:为节省算力,多数方法会先将图像降采样至低分辨率(Low-resolution)生成基础的Alpha Matte,再通过上采样还原尺寸[4],或者对图像进行分块处理[5, 6]生成基于块的Alpha Matte再通过上下文信息恢复原始尺寸。但这些方式会严重丢失高频细节,导致发丝断裂、边缘模糊,透明物体的透光质感更是无从谈起,最终结果与“高清”需求相去甚远。 如何在控制计算成本的同时,完整复原高分辨率图像中的精细前景信息?这一核心难题,成为制约视觉创作向“超高清时代”迈进的关键瓶颈。近年来,渐进式精细化(Progressive Refinement)[7]与分治策略(Divide-and-Conquer)[8, 9] 逐渐成为主流思路。通过由粗到精的多阶段优化,渐进式方法在低分辨率特征图上初步定位主体轮廓,再逐步恢复细节纹理,有效平衡了效率与精度;而分治策略则将大尺寸图像切分为重叠图块并行处理,辅以边缘融合算法消除拼接痕迹,在降低单次计算负荷的同时保留局部精细结构。两类思路虽各有侧重,但核心均在于重构图像信息的处理范式——不再追求全局一次性建模,而是通过空间或层级上的分解,实现对高分辨率输入的高效感知与精细化输出,为超高清时代下的视觉生产提供了切实可行的技术路径。但是这些方法仍面临上下文断裂与跨块一致性难题,尤其在处理大尺寸图像中长距离依赖关系时,局部优化易导致语义错位。图1给出了一些例子。

图1:在高分辨率自然图像上的抠图结果对比,(b)为原始高分辨率图像,(c)为对应低分辨率版本,(d)-(f)分别为三种方法生成的高分辨率前景遮罩。

为了克服现有方法的不足,智能算法研究中心与贵州民族大学以及电子科技大学中山学院合作研发出了一个开源的高分辨率自然图像抠图框架——HRIMF-AMR(High-Resolution Natural Image Matting by Refining Low-Resolution Alpha Mattes)[10]. HRIMF-AMR通过精炼低分辨率前景遮罩实现高分辨率自然图像抠图。实验结果表明,该方法不仅在高分辨率图像抠图领域的表现上比现有所有的抠图模型都更优秀,还帮助现有抠图方法提升了对于复杂场景下边缘细节的捕捉能力。目前,关于HRIMF-AMR的研究成果已在国际顶级期刊IEEE Transactions on Image Processing(JCR一区,影响因子13.7)上发表,并开放了代码(https://github.com/yexianmin/HRAMR-Matting)供研究者们使用和验证。

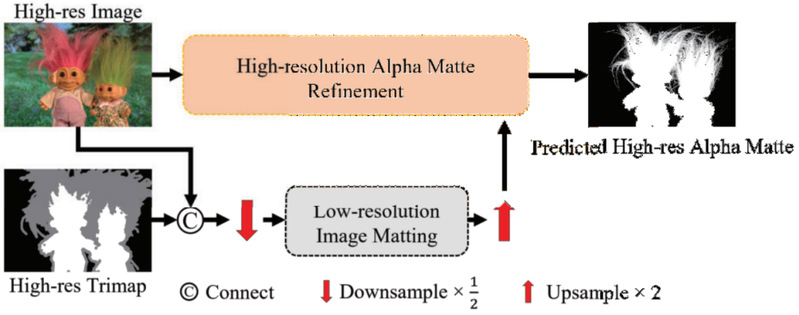

二、精细捕捉:精炼低分辨率前景遮罩的高清抠图 HRIMF-AMR是一种基于低分辨率遮罩精炼的高分辨率图像抠图新范式,通过高分辨率和低分辨率图像之间的差异特征提取来恢复细节信息,避免了直接在高分辨率空间中进行全局建模带来的计算负担。整体流程如图2所示。该方法首先在低分辨率输入上生成初步的前景遮罩,再利用高分辨率原图与之对应区域的语义差异,通过提出的细节差异特征提取器(DDFE)捕捉缺失的精细结构。同时引入遮罩细节分辨率差异(MDRD)损失函数,约束特征提取过程,强化对边缘纹理与透明区域的细节还原能力,使精炼后的高分辨率遮罩在复杂背景下仍保持自然过渡与精确边界。随后,在有限的计算成本下获得了一张清晰的高分辨率前景遮罩。

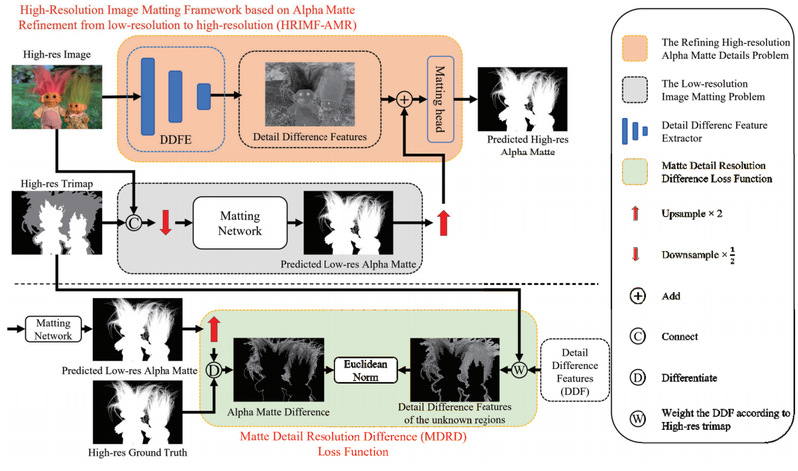

图2:HRIMF-AMR流程和这两个问题通过所提出的方法转换之间的关系。 HRIMF-AMR的具体框架结构如图3所示。下面我们将具体介绍该方法的核心思想和两个重要模块(DDFE和MDRD)。

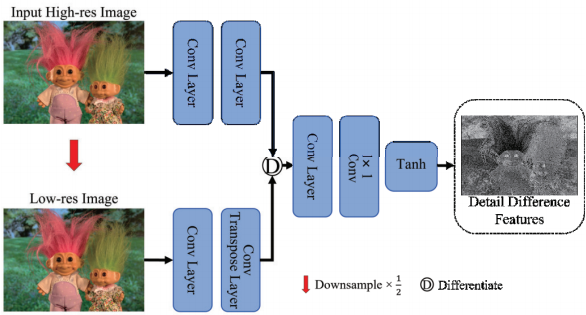

图3:HRIMF-AMR的整体结构以及MDRD损失函数的计算过程。 (一)核心思想 HRIMF-AMR的核心在于通过低分辨率遮罩的高效生成与高分辨率细节的精准还原之间的协同优化,实现计算效率与抠图质量的平衡。其关键在于不直接在高分辨率空间进行全局预测,而是利用低分辨率遮罩作为初始估计,结合原图的局部细节差异进行细节补偿。这一思想不仅降低了内存占用,还显著提升了模型对发丝、烟雾、玻璃等复杂边缘区域的刻画能力,为高分辨率图像抠图提供了可扩展且高效的解决方案。 (二)差异捕捉:细节差异特征提取器(DDFE) 针对低分辨率前景遮罩上采样后细节缺失的问题,团队专门设计了DDFE 核心模块,如图4所示。其关键点在于:高分辨率图像的细节损失并非随机,而是集中在特定高频区域。该模块通过对比高分辨率原图与降采样低分辨率图像的特征差异,精准定位并捕捉被丢失的发丝边缘、透明纹理等关键细节,为高分辨率前景遮罩精修提供 “精准素材”。

图4:DDFE的网络结构。 (三)细节约束:遮罩细节分辨率差异(MDRD)损失函数 为让模型更聚焦核心细节,团队引入遮罩细节分辨率差异(MDRD)损失函数。该损失的定义为:

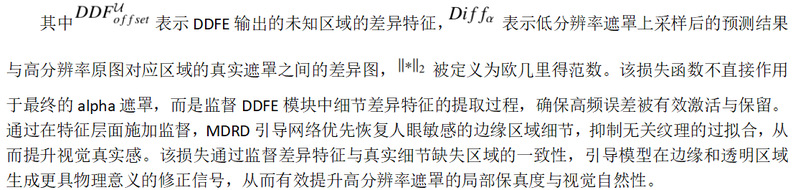

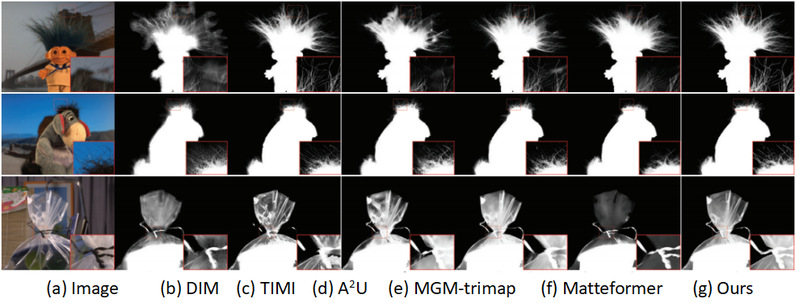

三、卓越性能:高分辨率抠图的实验验证 图5和图6展示了集成了HRIMF-AMR框架的抠图方法在通用抠图数据集Composition-1K的训练集上训练后的模型,在Transparent-460(高分辨率真实透明物体数据集)和Alphamatting(经典抠图基准数据集)上的测试结果,印证了HRIMF-AMR框架的优越性。

图5:集成了HRIMF-AMR框架的方法在Alphamatting高分辨率测试集上的视觉对比结果。

图6:集成了HRIMF-AMR框架的方法在Transparent-460 高分辨率测试集上的视觉对比结果。

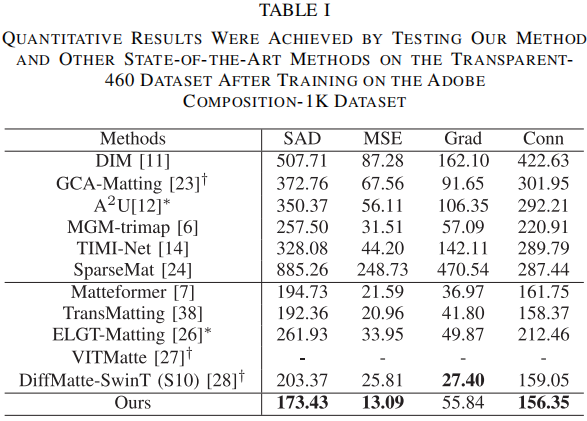

在定量实验方面,首先,为了比较模型的泛化能力,使用Composition-1K训练得到的模型在Transparent-460上进行测试,表现结果如表1所示。结果显示,本文方法在SAD、MSE和Conn三项指标上均显著优于现有方法,相比于基于Transformer的抠图方法,SAD降低9.84%到33.79%,MSE降低37.55%到61.44%,Conn也降低了1.70%到26.41%。这反映了集成了HRIMF-AMR的抠图方法在处理透明物体时,细节还原能力提升明显。

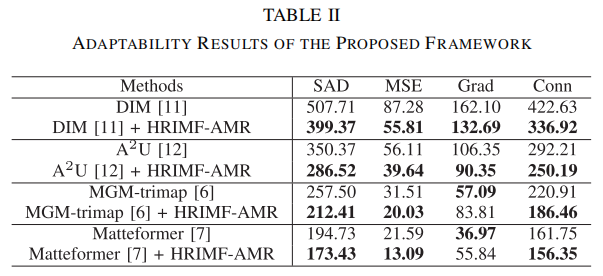

表2展示了HRIMF-AMR在适配到不同的抠图方法上的性能表现。这一表现帮助现有抠图方法提升了对于复杂场景下边缘细节的捕捉能力。

此外,本研究还涉及高分辨率补偿有效性的验证实验、在Transparent-460数据集上测试的消融实验、复杂性分析等。更多实验细节与数据结果,欢迎阅读完整论文。 综上所述,HRIMF-AMR在高分辨率图像抠图任务中展现出卓越的性能,不仅有效解决了高分辨率下边缘细节丢失的问题,还显著提升了透明物体边界的准确性与自然度。其分步优化策略兼顾了计算效率与结果质量,为复杂场景下的高质量图像抠图提供了可靠框架。实验结果表明,该框架在多种主流抠图模型上均能稳定提升性能,尤其在处理透明材质与复杂背景交织的场景时,展现出更强的鲁棒性与细节还原能力,进一步验证了其通用性与实用性。然而,当前方法在极端光照条件下的表现仍有提升空间,且对极薄透明结构的完全恢复仍具挑战。未来,智能算法研究中心将进一步探索,期望进一步提升HRIMF-AMR的性能,并推动高分辨率自然图像抠图技术的发展,使其在更多领域得到广泛应用。

参考文献 [1] J. Yao, X. Wang, S. Yang, and B. Wang, “ViTMatte: Boosting image matting with pre-trained plain vision transformers,” Inf. Fusion, vol. 103, Mar. 2024, Art. no. 102091. [2] G. Park, S. Son, J. Yoo, S. Kim, and N. Kwak, “MatteFormer: Transformer-based image matting via prior-tokens,” in Proc. IEEE/CVF Conf. Comput. Vis. Pattern Recognit. (CVPR), Jun. 2022, pp. 11686–11696. [3] H. Huang, Y. Liang, X. Yang, et al. Pixel-level Discrete Multiobjective Sampling for Image Matting, IEEE Transactions on Image Processing.(2019) 27(8): 3739-3751. [4] Z. Ke, J. Sun, K. Li, Q. Yan, and R. W. Lau, “MODNet: Real-time trimap-free portrait matting via objective decomposition,” in Proc. AAAI Conf. Artif. Intell., 2022, vol. 36, no. 1, pp. 1140–1147. [5] S. Lin, A. Ryabtsev, S. Sengupta, B. L. Curless, S. M. Seitz, and I. Kemelmacher-Shlizerman, “Real-time high-resolution background matting,” in Proc. IEEE/CVF Conf. Comput. Vis. Pattern Recognit., Jun. 2021, pp. 8762–8771. [6] H. Yu, N. Xu, Z. Huang, Y. Zhou, and H. Shi, “High-resolution deep image matting,” in Proc. AAAI Conf. Artif. Intell., 2021, vol. 35, no. 4, pp. 3217–3224. [7] Q. Yu et al., “Mask guided matting via progressive refinement network,” in Proc. IEEE/CVF Conf. Comput. Vis. Pattern Recognit. (CVPR), Jun. 2021, pp. 1154–1163. [8] 冯夫健, 黄翰, 吴秋霞, 等. 基于群体协同优化的高清图像前景遮罩提取算法[J]. 中国科学: 信息科学, 2020, 50(3): 424-437. [9] Y. Sun, C.-K. Tang, and Y.-W. Tai, “Ultrahigh resolution image/video matting with spatio-temporal sparsity,” in Proc. IEEE/CVF Conf. Com put. Vis. Pattern Recognit. (CVPR), Jun. 2023, pp. 14112–14121. [10] X. Ye, Y. Liang, M. Tan, F. Feng, L. Wang and H. Huang, High-Resolution Natural Image Matting by Refining Low-Resolution Alpha Mattes, in IEEE Transactions on Image Processing, vol. 34, pp. 3323-3335, 2025. 图/文:梁椅辉 |