| 当虚拟人物开口说话时,AI 如何让口型完美同步? |

| 发布时间: 2025-06-24 浏览次数: 11 |

|

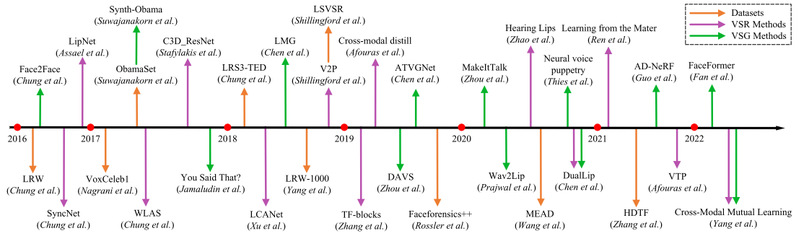

作者:曾梓峰 近年来,口型同步(Lip-sync)技术经历了从规则驱动建模到深度学习端到端合成的跨越式发展。这一演进过程离不开三大关键技术的推动:Speech2Vid、Wav2Lip 和 FaceFormer。本文将结合相关论文研究,系统解析它们的技术原理与核心优势

Speech2Vid:端到端生成的里程碑突破Speech2Vid [1]是最早实现从语音直接生成说话人视频的端到端深度学习框架之一。它摒弃了传统基于规则或分阶段建模的方法,首次实现了音频信号与参考图像的联合建模,输出具有身份一致性和口型同步性的高质量人脸视频。

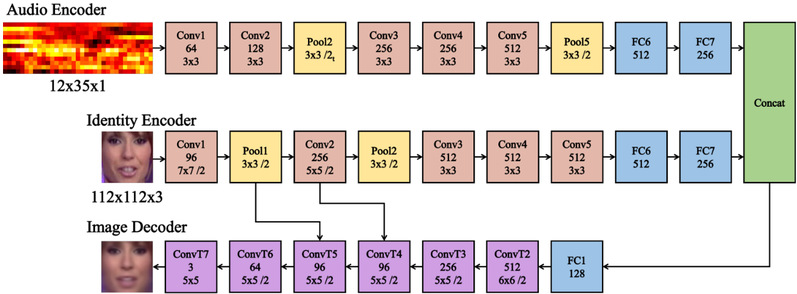

模型架构Speech2Vid 的整体架构由四个关键模块组成: 1. 音频编码器(Audio Encoder) 输入为原始音频波形(如 Mel 频谱或 MFCC 特征),通过多层卷积神经网络提取语音的时序特征。其创新之处在于直接处理原始音频,跳过了依赖音素或视素映射的传统方式,摆脱了语言和发音规则的限制。

2. 身份编码器(Identity Encoder) 基于目标人脸的静态参考图像,采用预训练的 VGG-M 网络提取身份特征(如面部轮廓、五官比例)。通过跳层连接机制将身份信息注入解码器,确保生成视频中的人脸始终保持身份一致性。 3. 图像解码器(Image Decoder ) 融合音频与身份编码器输出的特征,利用反卷积层逐步上采样生成视频帧。该模块采用自编码器结构,以 L1 重建损失为目标函数,最小化生成图像与真实图像之间的像素差异。 4. 去模糊模块(Deblurring Module) 作为后处理模块,使用预训练 CNN 提升生成视频的清晰度,缓解逐帧生成带来的模糊问题。

核心优势作为语音驱动视频生成领域的开创性工作,Speech2Vid 在多个方面展现出显著优势: - 端到端生成流程:从音频和参考图像直接生成视频,省去了传统方法中分阶段建模的复杂流程,提升了系统的实时性和集成度。 - 身份一致性保留:通过跳层连接机制有效防止人脸变形或身份丢失;引入多张参考图像可进一步增强身份表达的多样性。 - 跨模态时间对齐能力:借助 SyncNet 实现音频与视频的时间校正,初步达成唇形与语音的同步,为后续时序建模奠定基础。 - 良好的泛化性能:基于无监督训练策略,能够处理未见过的身份与语音组合,适用于虚拟主播、影视配音等开放域场景。

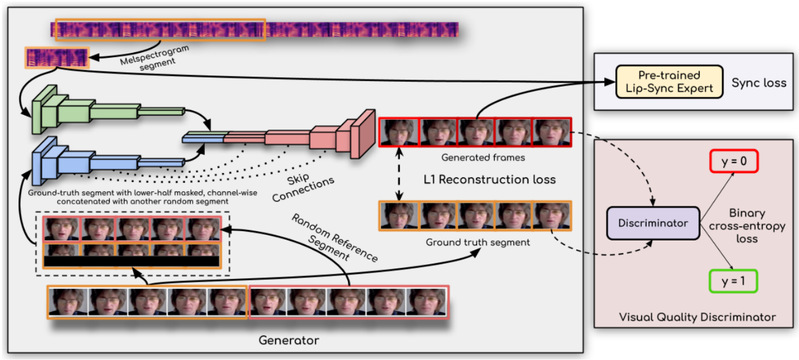

存在挑战尽管 Speech2Vid 具有开创意义,但仍面临一些局限: - 重建损失的局限性:L1 损失关注全局像素误差,忽略了语音驱动区域(如嘴部)的重要性差异,导致部分区域生成质量不高。 - 缺乏时间连贯性建模:各帧独立生成,未考虑帧间动态关系,易出现突变现象。 - 音频-视频同步精度不足:缺乏显式的时序对齐优化机制,可能出现唇形滞后或提前等问题。 - 视觉质量受限:L1 损失容易导致图像模糊,且身份特征建模能力有限,影响最终视频的真实感。 Wav2Lip:GAN 驱动的创新解决方案Wav2Lip[2] 是一种基于 GAN 的语音驱动视频生成模型,旨在提升口型同步准确性和生成视频的视觉质量。其核心思想是通过两个功能明确的鉴别器分别监督口型同步性和视觉真实性,从而引导生成器输出高质量、同步良好的说话人视频。

模型架构Wav2Lip 的整体结构包括一个生成器和两个鉴别器: - 生成器(Generator) 包含身份编码器、语音编码器以及融合机制。身份编码器通过残差卷积层提取参考帧 R 的特征,并与姿态先验 P 拼接,以维持头部姿态的一致性;语音编码器则对输入语音 S 进行编码,并将其与面部特征融合,确保生成的唇形运动与语音内容高度匹配。 - 口型同步鉴别器(Lip-sync Discriminator) 基于 SyncNet 改进而来,接收彩色图像序列作为输入,结构上引入残差跳跃连接,增强模型深度。采用余弦相似度结合二元交叉熵损失进行训练,在 LRS2 测试集上的同步判断准确率达到 91%,远高于 LipGAN的 56%。 - 视觉质量鉴别器(Visual Quality Discriminator) 用于提升生成图像的真实性与清晰度,不参与口型同步性判断。其结构由多个卷积块组成,每个块包含卷积层和 LeakyReLU 激活函数,通过对抗训练机制减少模糊和伪影。

核心优势Wav2Lip 在语音驱动视频生成领域展现出多项技术突破:

- 更高的口型同步准确性:引入高性能口型同步鉴别器,结合新提出的“口型同步误差距离”(LSE-D)和“口型同步误差置信度”(LSE-C)指标,在多个数据集上均取得优于现有方法的同步表现。 - 更优的视觉质量:视觉质量鉴别器的引入显著改善了生成图像的清晰度和细节表现,FID 指标表明其生成图像与真实图像分布更加接近。 - 更具实用价值的评估体系:提出针对口型同步任务的评估框架,解决了传统评估方式在实际应用中的不一致性和局限性,使不同方法间的比较更加公平可靠。 - 广泛的适用性:在人类感知实验中表现出色,超过 90% 的用户偏好选择 Wav2Lip 生成的视频,说明其在视听体验方面更贴近人类感知需求。

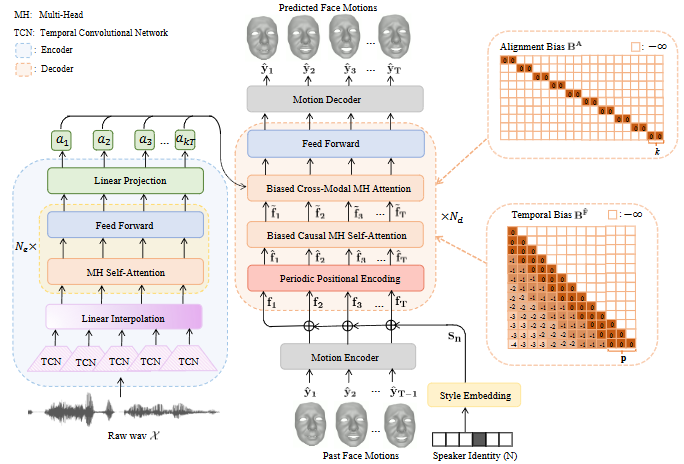

FaceFormer:Transformer 重塑 3D 动画FaceFormer[3] 是一种基于 Transformer 架构的语音驱动 3D 面部动画生成模型,采用序列到序列的学习范式,实现从语音到 3D 面部网格动画的精准映射。

模型架构FaceFormer 的核心结构由编码器和解码器两部分组成: - 编码器(Encoder) 基于自监督预训练语音模型 wav2vec 2.0 构建,首先通过时间卷积网络(TCN)提取音频特征,随后送入由多头自注意力和前馈网络组成的 Transformer 编码器,捕捉语音中的上下文语义信息。为实现音频与面部运动的时间对齐,编码器还引入线性插值层进行重采样。此外,模型通过可学习的风格嵌入层融入说话者身份信息,增强动画的个性化表达能力。 - 解码器(Decoder) 采用周期性位置编码(PPE)、有偏因果多头自注意力机制和有偏交叉模态注意力机制,实现对面部运动序列的高质量预测。其中,PPE 增强了模型对长序列的建模能力;因果注意力机制保证了时序因果性并捕获远距离依赖;交叉模态注意力机制则增强了音频与面部动作之间的语义对齐。

核心优势FaceFormer 在语音驱动 3D 面部动画领域展现出以下突出特点: - 强大的长音频上下文建模能力:利用 Transformer 的全局注意力机制,有效捕捉语音中的长距离依赖关系,生成的表情变化更加自然流畅,避免了表情突变或语义不协调的问题。 - 充分利用自监督语音表示:引入 wav2vec 2.0 自监督语音模型,在数据稀缺条件下依然能提取高质量语音特征,尤其在闭口音素(如 /b/、/m/、/p/)的处理上效果显著,同时增强了模型对不同说话者、口音和语种的适应能力。 - 创新的模态对齐与注意力机制:提出偏置交叉模态注意力和有偏因果注意力机制,显著提高了音频与面部动作之间的对齐精度,使生成的唇形与语音高度同步,情感表达更丰富细腻。 - 灵活的周期性位置编码策略:通过周期性位置编码(PPE)提升模型对长序列的泛化能力,确保在处理不同长度音频输入时仍能保持稳定的注意力聚焦和动作一致性,增强了模型在实际应用中的通用性。 技术演进与未来展望从单阶段生成(Speech2Vid)→ 对抗精调(Wav2Lip)→ 几何感知的Transformer架构(FaceFormer),口型同步技术正经历三重跃迁: 精度提升:从离散帧同步进化为高精度时序对齐 泛化增强:从实验室数据到真实场景适配 维度扩展:从平面视频到3D虚拟形象

随着多模态大模型(如PaLM-E)与实时渲染技术(NeRF)的突破,未来的虚拟人或将实现: ✅ 实时多语言口型生成 ✅ 情感驱动的微表情控制 ✅ 虚实融合的沉浸式交互

虚实世界的最后一公里,或许就藏在每一次唇齿开合之间。

参考文献: [1] Chung J S, Jamaludin A, Zisserman A. You said that?[J]. arXiv preprint arXiv:1705.02966, 2017. [2] Prajwal K R, Mukhopadhyay R, Namboodiri V P, et al. A lip sync expert is all you need for speech to lip generation in the wild[C]//Proceedings of the 28th ACM international conference on multimedia. 2020: 484-492. [3] Fan Y, Lin Z, Saito J, et al. Faceformer: Speech-driven 3d facial animation with transformers[C]//Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2022: 18770-18780. |