| AI是如何学会说人话的:语音合成技术演进 |

| 发布时间: 2025-05-12 浏览次数: 10 |

|

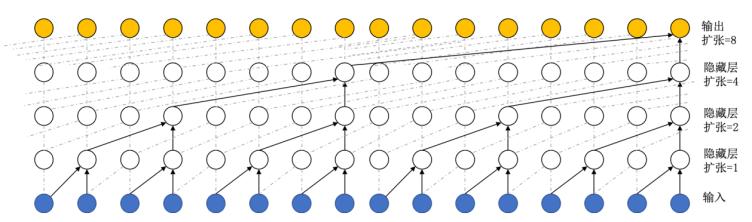

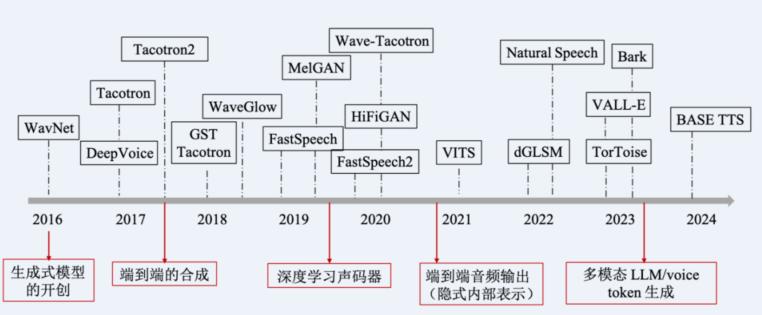

近年来,语音合成(Text-to-Speech, TTS)技术经历了从机械声到近乎真人语音的跨越式发展。这一进程离不开三大核心技术——WaveNet、Tacotron 2和VITS的突破性贡献。它们分别代表了深度学习在语音生成领域的不同技术路径,本文将结合论文研究,解析其原理、优势与应用场景。  一、WaveNet:生成式模型的开创者 2016年,DeepMind提出的WaveNet [1]首次实现了直接从原始音频波形生成语音,其核心创新在于使用了扩张因果卷积(Dilated Causal Convolution)。这一技术通过扩展卷积核的间隔,使得模型能够捕捉长达数千个时间步的上下文依赖,从而生成高保真音频。这种方法极大地提升了音频生成的质量,使其接近真实人声,克服了传统方法中常见的音质不自然和断裂感问题。 为了降低计算复杂度,WaveNet引入了μ-law量化技术,将原始的16位音频压缩为256个离散值。这不仅减少了模型的计算需求,还使得其能够在更高效的硬件上运行。WaveNet在多说话人语音生成、音乐合成甚至语音识别等任务中也表现出色,成为语音合成技术的重要基石。实验结果表明,WaveNet在自然度评分中达到了4.0以上,接近真人录音水平(4.55),明显超越了传统拼接式和参数化方法,标志着从传统拼接合成到深度学习驱动的生成模型的重大进步。这一成果为后续端到端语音合成奠定了技术基础。

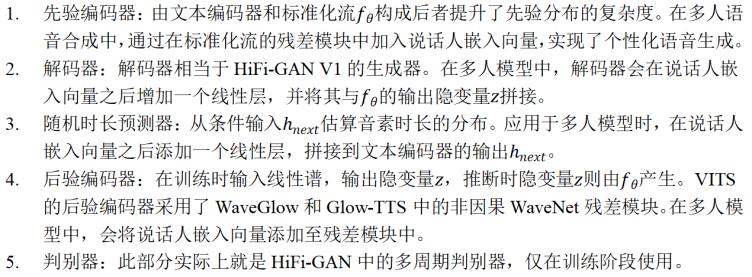

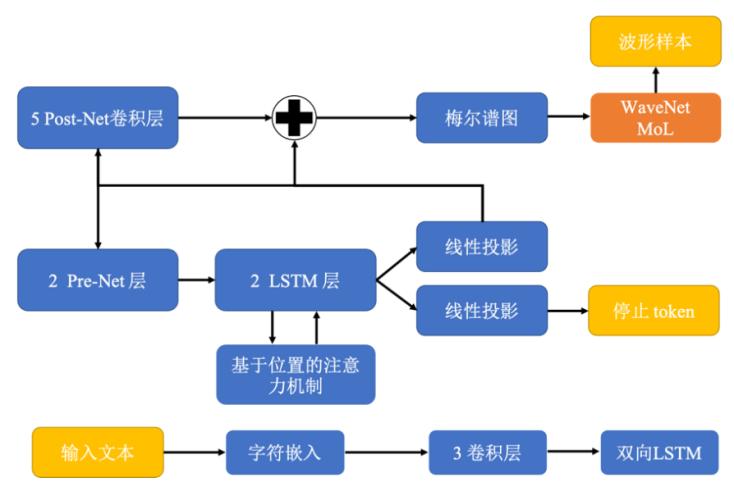

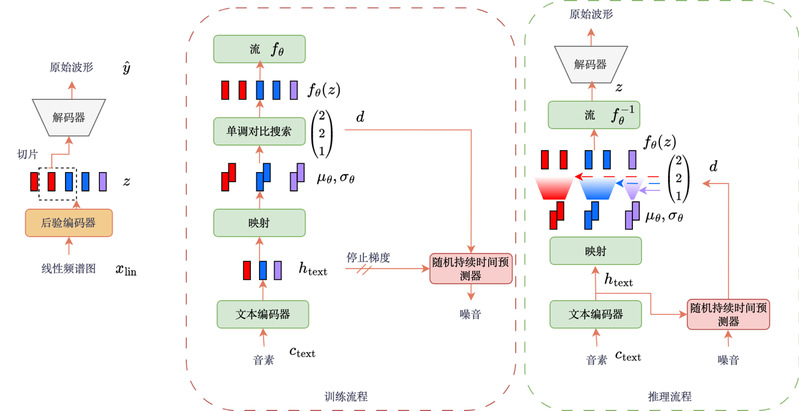

https://wpyt.microcomputation.com/login论文送审和答辩季,有需要可以用我们智能算法研究中心出品的“文品易通”智能体,提前充分检查论文的问题,有备无患。学生免费使用,覆盖各个专业,本科和研究生都可以用。 二、Tacotron 2:端到端合成的里程碑  Tacotron 2是由Google团队提出的另一项重大技术突破,它通过简化语音合成的流程,推动了TTS系统的端到端发展。Tacotron 2采用了两阶段架构。第一阶段是序列到序列(Seq2Seq)模型,它将输入的文本直接映射为梅尔频谱图。梅尔频谱图是一种通过模拟人耳听觉特性来增强低频信号并抑制高频噪声的频率表示形式,能够大大提升合成语音的自然度。在第二阶段,Tacotron 2使用了改进的WaveNet声码器来将梅尔频谱图转化为最终的音频波形。与传统的Griffin-Lim算法相比,WaveNet声码器能够通过预测16位音频样本的混合逻辑分布来减少相位估计误差,从而生成更为精细、逼真的语音。Tacotron 2的端到端设计使得其不再需要依赖手工标注的语言学特征(如音高、时长等),并通过动态停止机制自适应地控制语音的长度,进一步提升了模型的灵活性和应用性。在多项MOS测试中,Tacotron 2的评分高达4.53,与专业录音的评分(4.58)几乎无异,使其成为工业级TTS系统的标杆。 三、VITS:单阶段多样化的未来方向 VITS(Variational Inference with Adversarial Learning for TTS)[3] 是2021年提出的一项创新技术,它首次通过条件变分自编码器(VAE)和对抗训练相结合,实现了单阶段端到端并行生成。这一技术的核心在于其能够同时生成高质量音频并控制语音的时长、风格等细节,使得语音合成变得更加灵活和多样化。  VITS的总体结构可以分为5块:

VITS的创新在于它不仅解决了传统模型生成速度慢和效果不稳定的问题,还通过引入隐变量建模和对抗学习,显著提升了语音合成的自然度和多样性,使其在实时交互和个性化语音生成等应用中具有广阔的前景。  科研项目验收的靠谱第三方测评帮手,超过300多项国家级、省部级科技项目验收的经验。服务内容:提供软件功能、性能、安全检测,软件项目验收测试,软件产品登记测试等。资质:提供带有CMA、CNAS权威认证的检测报告。市场合作:sales@microcomputation.com 公司地址:华南理工大学国家大学科技园顺德创新园区7座9楼903 公司官网:http://www.microcomputation.com/ 联系方式:崔生13316328117 卢生13073042423 四、总结 语音合成技术的演进经历了从分阶段模型到端到端系统的转变。在生成方式上,WaveNet依赖自回归逐点生成,虽然能够实现极高的保真度,但其生成速度较慢。Tacotron 2则通过两阶段架构(频谱预测与波形生成),在保证语音质量的同时提高了生成效率。而VITS则引入了变分推断与对抗学习,实现了单阶段端到端并行生成,不仅提升了速度,也减少了计算复杂度,成为当前速度最快的技术。 在自然度与多样性方面,WaveNet受限于固定条件输入(如语言学特征),因此其生成的语音多样性较低。Tacotron 2通过梅尔频谱作为中间表示,增强了语音的自然度,但语音的多样性仍然受到外部控制的影响。而VITS则通过随机时长预测和隐变量建模,使得语音的节奏和风格可以实现灵活的调控,大大提升了多样性与自然度的表现。 在应用场景方面,WaveNet因其高保真性,广泛应用于语音和音乐合成。Tacotron 2则因其稳定性和端到端的设计,成为工业级TTS系统的首选技术。VITS则在实时交互和个性化语音生成中展现了巨大的潜力,尤其是在需要快速响应和个性化定制的场景中具有广泛的应用前景。 展望未来,语音合成技术的方向愈发清晰。首先,VITS的并行生成模式为实时语音交互铺平了道路,能够在更短时间内提供高质量的语音反馈。其次,个性化定制将成为语音合成技术的一个重要方向,通过结合少样本学习,用户可以仅用1分钟的录音数据来定制专属语音,使得个性化语音生成变得更加普及。最后,多模态融合将是语音合成技术未来发展的一个重要趋势,语音与文本、图像等多种模态的协同生成将创造出更为沉浸式的交互体验,为用户带来更丰富、灵活的互动感受。 参考文献: [1] van den Oord A, Dieleman S, Zen H, et al. WaveNet: A Generative Model for Raw Audio[C]//Proc. SSW 2016. 2016: 125-125. [2] Shen J, Pang R, Weiss R J, et al. Natural tts synthesis by conditioning wavenet on mel spectrogram predictions[C]//2018 IEEE international conference on acoustics, speech and signal processing (ICASSP). IEEE, 2018: 4779-4783. [3] Kim J, Kong J, Son J. Conditional variational autoencoder with adversarial learning for end-to-end text-to-speech[C]//International Conference on Machine Learning. PMLR, 2021: 5530-5540. |